Оценка соответствия технологий искусственного интеллекта в градостроительной деятельности

Гарбук С.В.,

к.т.н., с.н.с., директор по научным проектам НИУ ВШЭ,

председатель технического комитета по стандартизации № 164 «Искусственный интеллект»

Шамина Е.О.,

к.т.н., заместитель директора по научным проектам НИУ ВШЭ

Особенности алгоритмов искусственного интеллекта

Развитие современных средств вычислительной техники, совершенствование инфраструктуры сбора, передачи и хранения информации, а также разработка новых методов обработки данных открывают широкие возможности по созданию и применению технологий искусственного интеллекта (ИИ).

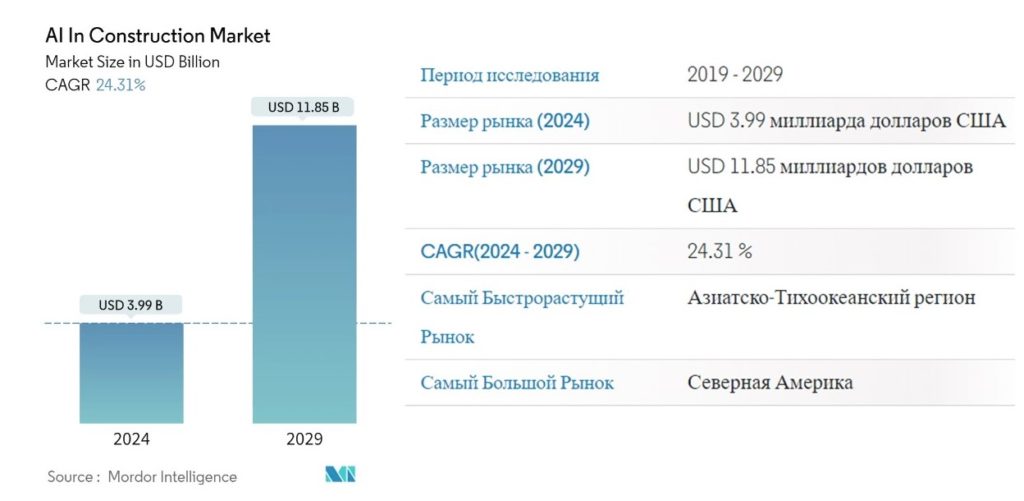

В настоящее время накоплены большие объемы эмпирических данных и разработаны средства математического моделирования, которые могут быть использованы для создания алгоритмов машинного обучения, обеспечивающих решение различных задач обработки данных в градостроительстве. На сегодняшний день рынок ИИ в строительстве оценивается в $3,99 млрд в 2024 году, а к 2029 году ожидается, что он составит $11,85 млрд, что означает среднегодовой темп роста около 25 % (рисунок 1, [1]).

Рис. 1 Доля технологий ИИ в общем объеме строительного рынка [1].

Алгоритмы ИИ универсальны, могут применяться для решения широкого спектра практических задач в рамках строительной отрасли на всех этапах жизненного цикла строительного объекта [2]. Среди основных направлений применения ИИ можно выделить:

- поддержку принятия решений при проведении инженерных изысканий;

- автоматизацию архитектурно-строительного проектирования;

- контроль процессов строительства, реконструкции, капитального ремонта и сноса;

- управление строительно-дорожной техникой;

- оптимизацию логистических процессов;

- неразрушающий контроль и виртуальные испытания строительных объектов;

- автоматизацию бизнес-процессов строительных компаний.

В то же время, технологии ИИ, в том числе, основанные на методах машинного обучения (МО), характеризуются следующими особенностями, учет которых необходим при их практическом применении [3]:

- алгоритмы ИИ принципиально не обладают полной интерпретируемостью.

Для существенной части операций над данными, предусмотренных алгоритмом ИИ, человеком сколь угодно высокой квалификации не может быть принято решение о правильности или неправильности этих операций на основании критериев, истинность которых подтверждена внешними соображениями (аксиоматические постулаты, доказанные теоремы, подтвержденные экспериментально модели, логически объяснимые зависимости и т.п.);

- при создании алгоритмов ИИ используются специальным образом подготовленные наборы данных (НД), содержащие примеры решения конкретных прикладных интеллектуальных задач.

Алгоритмы ИИ обладают обобщающей способностью, благодаря которой вариативность условий прикладной задачи ИИ для обучающего набора данных (НД) может быть существенно меньше, чем при дальнейшем практическом применении алгоритма;

- во многих случаях в процессе практического применения алгоритмов ИИ возникает возможность расширения обучающих НД за счет дополнительных примеров решения прикладных задач в новых условиях, не предусмотренных исходными обучающими НД.

Такие дополненные обучающие НД могут быть использованы для модификации алгоритмов, направленной на повышение их качества. Уровень конфиденциальности данных в процессе их накопления и обобщения на стадии эксплуатации систем ИИ может возрастать;

- универсальность алгоритмов ИИ позволяет использовать их для автоматизации сложных задач обработки данных, не поддающихся решению с помощью одних лишь полностью интерпретируемых алгоритмов.

Это приводит к существенному повышению уровня автоматизации информационных процессов и, как следствие, к делегированию системам ИИ значительного количества задач обработки данных, ранее выполнявшихся человеком вручную, с соответствующим переносом ответственности за некорректные действия по обработке данных с человека-оператора на других субъектов права. Данное обстоятельство позволяет относить ИИ к технологиям, для которых особо остро встает вопрос правовой, экономической и социальной приемлемости применения;

- в том случае, если системы ИИ предназначены для автоматизации процессов интеллектуальной обработки данных, ранее выполнявшихся человеком вручную, должна быть обеспечена возможность сравнения характеристик качества используемых алгоритмов ИИ и функциональных возможностей человека (представительной группы квалифицированных операторов).

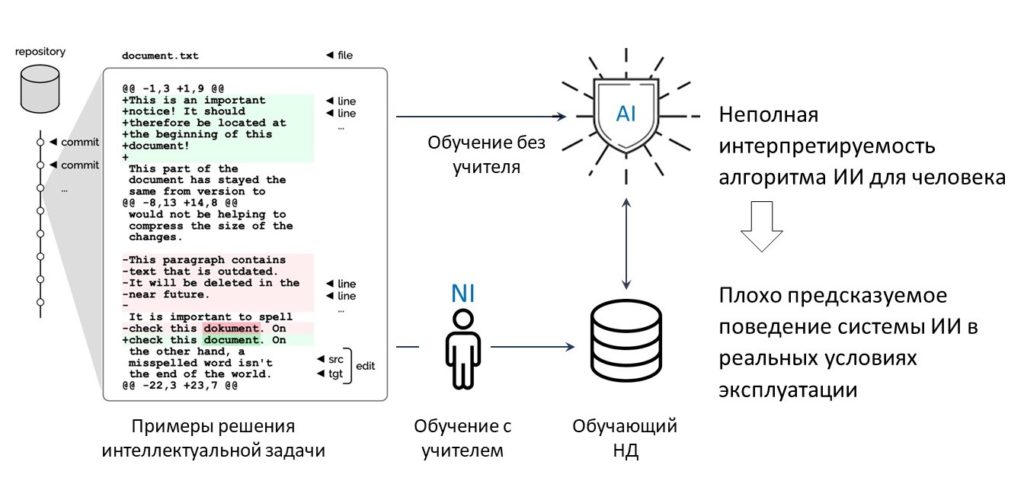

Таким образом, методы машинного обучения, используемые в системах ИИ, представляют собой плохо интерпретируемые алгоритмы, что приводит к отсутствию полной понятности (объяснимости) данных алгоритмов для человека и, как следствие, плохо предсказуемому поведению системы ИИ в реальных условиях эксплуатации, отсутствию в поведении систем «здравого смысла», подверженности воздействию т.н. «состязательных» атак на исходные данные (Рисунок 2).

Рис. 2 Особенности алгоритмов ИИ.

Риски применения технологий ИИ с неподтвержденной функциональной корректностью

Некорректная работа алгоритмов ИИ наблюдается при определённых (сложно предсказуемых):

- условиях эксплуатации (сочетаниях параметров внешней среды и объекта измерения);

- небольших (незначительных с точки зрения здравого смысла человека) неумышленных или умышленных искажениях исходных данных, подаваемых на вход алгоритма ИИ;

- характеристиках наборов данных, используемых для дообучения алгоритмов ИИ на стадии их эксплуатации.

В работе [4] рассмотрен подход к обеспечению безопасности систем ИИ, основанный на формировании и соблюдении требований к различным информационным компонентам.

В общем случае, на стадиях жизненного цикла системы ИИ так или иначе используются ряд информационных компонент (данные, формализованные описания, модели):

- функциональные требования к системам (ФХ);

- описание предусмотренных условий эксплуатации (ПУЭ);

- эталонные архитектуры программного обеспечения, реализующего алгоритмы МО;

- обучающие и дообучающие НД;

- тестовые НД;

- входные данные и результаты обработки.

Важно отметить, что подобный набор информационных компонент специфичен для систем ИИ,

так что особенности систем обработки данных на основе алгоритмов МО полностью обуславливаются этим набором как минимально достаточным. При этом в составе системы ИИ могут присутствовать иные компоненты (например сенсоры, средства передачи, обработки, хранения и отображения информации, исполнительные устройства и т.п), также определяющие качество и безопасность работы системы, но не являющиеся специфическими для систем обработки данных на основе алгоритмов машинного обучения.

При этом требования к информационным компонентам могут быть двух видов [4]:

- требования целостности, заключающиеся в корректности формирования информационной компоненты и в предотвращении её умышленных и непреднамеренных искажений;

- требования конфиденциальности, заключающиеся в предотвращении компрометации соответствующих данных.

Анализ рисков, проявляющихся при невыполнении указанных требований, показал, что возможными негативными последствиями, являются [4]:

- существенное возрастание ошибки оценивания ФХ при тестировании (испытаниях) систем ИИ

за счет смещения (как правило, в сторону завышения характеристик) и возрастания случайной составляющей погрешности оценок при снижении вариативности тестовых НД. Неточное понимание функциональности систем существенно усложняет или даже делает невозможным принятие эксплуатирующей стороной рациональных решений об использовании системы ИИ на практике; - деградация ФХ, ограничивающая возможность применения систем в реальных условиях эксплуатации. Причины такой деградации заключаются либо во внесении преднамеренных искажений в обучающие НД и архитектуру системы ИИ, в результате чего ФХ ухудшаются в предусмотренных условиях эксплуатации, либо в создании злоумышленниками в ходе реального применения системы ИИ условий применения, существенно отличающихся от предусмотренных разработчиками системы (ПУЭ). Во втором случае ФХ систем сохраняют гарантированные разработчиком значения в предусмотренных условиях эксплуатации, однако деградируют в реальных условиях, выходящих за рамки ПУЭ;

- нежелательное нарушение конфиденциальности сведений о технических характеристиках и особенностях применения системы ИИ, приводящее, например, к повышению эффективности деструктивных информационных воздействий на систему злоумышленниками, в том числе,

за счет оптимизации способов искажения входных данных системы ИИ и т.п.; - компрометация сведений о физических и юридических лицах, интересы которых так или иначе затрагиваются при реализации процессов ЖЦ системы ИИ (заинтересованные лица СИИ).

Наиболее опасные угрозы и, соответственно, наиболее важные характеристики и требования связаны с обеспечением безопасности жизни и здоровья людей, а также с предотвращением крупных инцидентов экологической безопасности. Например, некорректная работа систем автоматизации движения строительно-дорожной техники может привести к наезду на рабочих, находящихся в зоне ее функционирования. Так или иначе, для систем повышенной опасности необходимо иметь гарантии того, что уровень формируемых ими угроз не превышает уровень, демонстрируемый квалифицированными людьми-операторами, выполняющими соответствующие задачи управления и обработки данных в ручном режиме.

Особый вид требований связан с предотвращением угроз информационной безопасности (ИБ)

в отношении заинтересованных лиц, вызванных нарушением функциональной корректности систем ИИ. Если некорректная работа систем может привести к реализации деструктивных информационно-психологических воздействий, то в формировании требований ИБ к таким системам ИИ заинтересованы соответствующие государственные регуляторы.

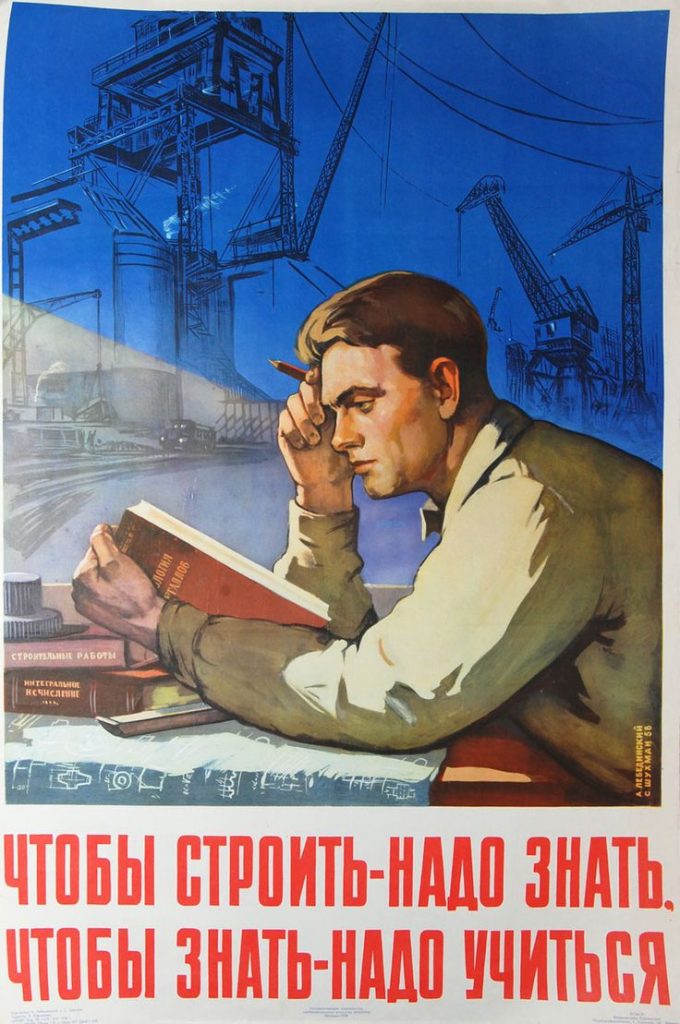

Для многих прикладных систем ИИ специфичны угрозы этического характера и другие угрозы, предотвращение которых достигается реализацией мер т.н. «мягкого» права. Примерами таких систем, используемых прямо или косвенно на стадиях жизненного цикла строительных объектов, могут выступать системы в кредитно-финансовой сфере (применяемые в процессе получения финансирования на строительство объекта), в области образования (применяемые при подготовке отраслевых специалистов различной квалификации), поисково-справочные, маркетинговые и иные информационные системы (применяемые на этапах анализа рынка и архитектурно-строительных изысканий), использующие методы персонализации на основе ИИ.

Для систем ИИ, не предназначенных непосредственно для решения задач в области безопасности

и не представляющих угрозы для жизни, здоровья людей и окружающей природной среды, отклонение функциональных характеристик от установленных требований ограничивается ухудшением потребительских свойств систем и может интерпретироваться, как реализация угроз экономической безопасности акторов ИИ. В частности, некорректная работа систем, осуществляющих преобразование строительной документации к цифровому виду (восстановление недостающих атрибутов за счёт категорирования объектов, контекстно-зависимое распознавание) или моделирование жизненного цикла конкретного объекта с целью прогнозирования денежных и временных затрат на строительство, повлечет за собой экономические потери субъекта их использующего. В формировании требований и предотвращении соответствующих угроз в таком случае заинтересованы, прежде всего, разработчики, поставщики и потребители систем ИИ.

Модель безопасности систем ИИ

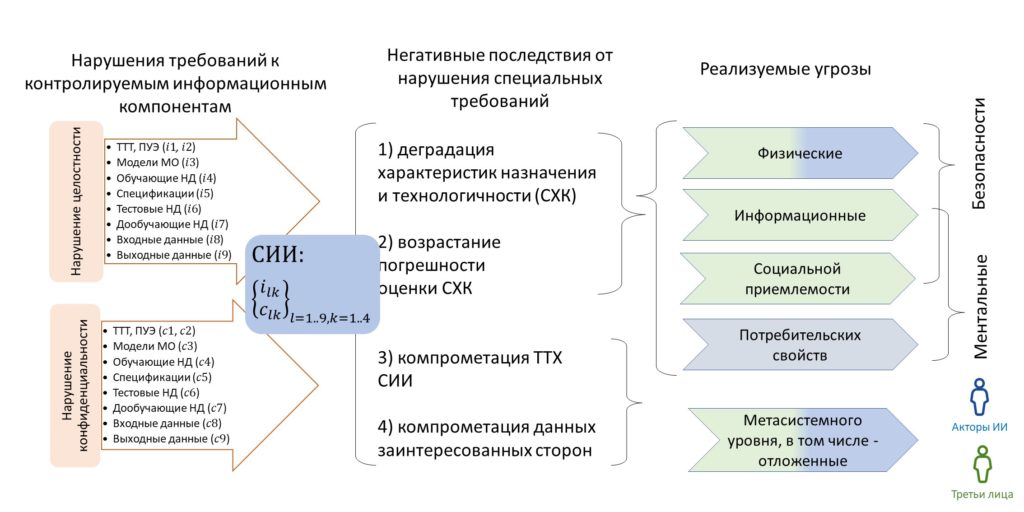

Схема, поясняющая предложенную специальную модель безопасности систем ИИ, представлена

на рисунке 3. На основе данных о имеющихся и потенциальных несоответствиях требованиям в области целостности и конфиденциальности различных информационных компонент системы ИИ и матрицы чувствительности системы ИИ к этим несоответствиям оценивается вектор возможных негативных последствий, содержащий параметры функциональной корректности системы ИИ и конфиденциальности данных о системе и заинтересованных сторонах. Параметры функциональной корректности далее подвергаются дополнительному анализу с учетом прикладного значения и особенностей применения систем ИИ для оценивания рисков в области физической, ментальной (ИБ и социальная приемлемость) и экономической безопасности, после чего полученные оценки в сочетании с ранее полученными оценками рисков ИБ используются в качестве выходных данных модели.

Рис. 3 – Специальная модель безопасности систем ИИ

Предложенная модель [4] построена с учетом общих особенностей систем обработки данных на основе алгоритмов машинного обучения, иллюстрирует структуру зависимостей различного рода рисков, обусловленных несоответствием информационных компонент системы ИИ различным требованиям, установленным нормативно-техническими документами.

Национальная система оценки соответствия технологий ИИ

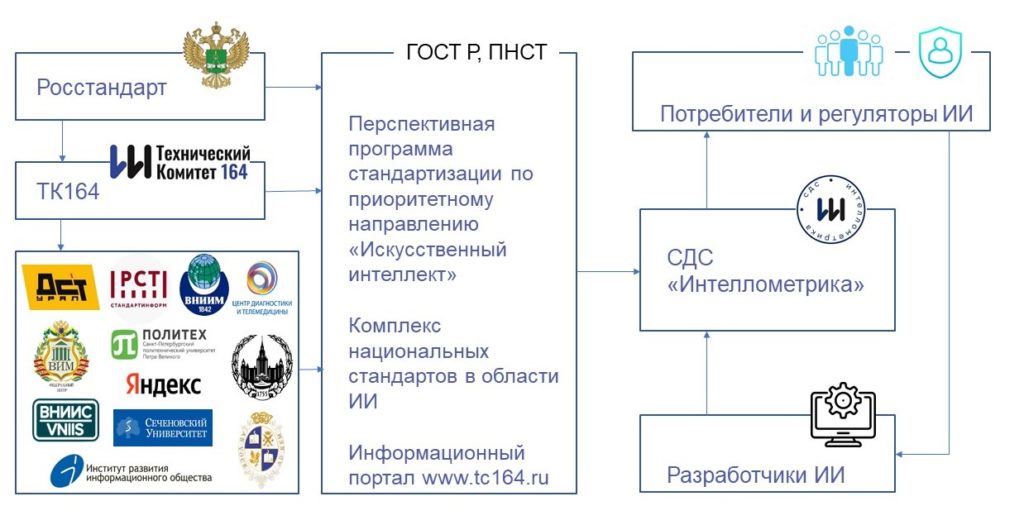

Минимизировать негативные последствия, возникающие вследствие нарушения целостности информационных компонент, позволяет национальная система оценки соответствия технологий ИИ. Под оценкой соответствия понимается прямое или косвенное определение соблюдения требований, предъявляемых к технологиям ИИ [5]. Соответственно, структура национальной системы оценки соответствия технологий ИИ включает в себя два блока работ: стандартизацию и подтверждение соответствия (рисунок 4).

Рис. 4 Национальная система оценки соответствия технологий ИИ

Деятельность по разработке комплекса национальных стандартов осуществляется в рамках технического комитета по стандартизации № 164 «Искусственный интеллект» (ТК 164) на основе перспективной программы стандартизации (ППС) по приоритетному направлению «Искусственный интеллект» на 2021-2024 годы, утвержденной Министерством экономического развития Российской Федерации и Федеральным агентством по техническому регулированию и метрологии [3].

ППС разработана в рамках федерального проекта «Искусственный интеллект» в декабре 2020 (актуализирована в декабре 2023 года) и включает:

- описание принципов стандартизации ИИ;

- стандарты общего назначения (как разработанные на основе международных, так и разрабатываемые впервые);

- метрологические стандарты, направленные на унификацию способов измерения функциональных характеристик прикладных технологий ИИ в основных отраслях экономики и социальной сферы.

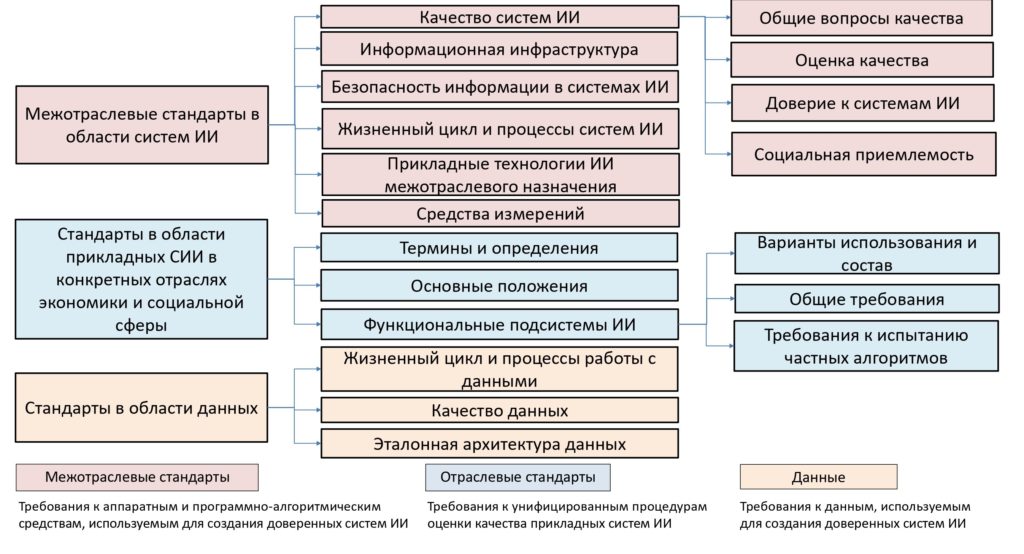

Комплекс национальных стандартов (рисунок 5) разрабатывается при участии ключевых разработчиков и потребителей технологий ИИ, научных и общественных организаций, таких как

МГУ имени М.В. Ломоносова, ФАУ «РОСДОРНИИ», ВНИИМ им. Д.И. Менделеева, ФГАУ «ФЦПР ИИ», ПАО «Сбербанк», ООО «Яндекс», ФГБУ «Институт стандартизации», ФГАОУ ВО ВолГУ и др.

Рис. 5 – Структура комплекса национальных стандартов в области ИИ

Разработанные документы образуют нормативно-техническую базу системы добровольной сертификации в области ИИ «Интеллометрика» (зарегистрирована Росстандартом в едином реестре систем добровольной сертификации 26.12.2023, № РОСС RU.В2915.04ВШЭ0. Это первая в России специализированная система для проведения сертификационных испытаний технологий ИИ, позволяющая снять нормативно-технические барьеры, препятствующие эффективному внедрению СИИ в различные отрасли экономики и социальной сферы с учетом необходимости представления гарантий безопасности и функциональности этих систем (рисунок 6).

Рис. 6 – Организационная структура СДС «Интеллометрика»

СДС «Интеллометрика» функционирует в соответствии со следующими принципами:

- объективность – испытания должны проводиться таким образом, чтобы исключить возможное влияние разработчиков и других заинтересованных лиц на результаты испытаний;

- подконтрольность – в формировании принципов функционирования и методических оснований СДС должны принимать участие представители государственных регуляторов, ключевых потребителей, разработчиков систем ИИ, представители профильных научных организаций и другие заинтересованные специалисты;

- представительность – испытания должны проводиться с использованием тестовых наборов данных, обеспечивающих получение репрезентативных оценок характеристик безопасности и функциональности систем ИИ в предусмотренных условиях эксплуатации;

- прикладная направленность – организация и проведение испытаний систем ИИ должны осуществляться при непосредственном участии отраслевых центров компетенций, обладающих необходимыми сведениями об особенностях применения систем ИИ в конкретных прикладных областях;

- унификация – проведение испытаний должно осуществляться на базе единых (межотраслевых) научно-методологических подходов, наиболее полно учитывающих отечественный и международный опыт в области тестирования систем ИИ, в том числе – на базе алгоритмов машинного обучения.

СДС «Интеллометрика» носит межотраслевой характер что позволяет разработать и внедрить единую методологию оценки соответствия функциональной корректности, а также координировать деятельность по разработке методов и средств (включая НД) оценки технологий ИИ с учетом отраслевой специфики. Данный подход способствует унификации процедур оценки соответствия, предотвращению дублирования работ, соблюдению единых требований к формированию НД.

Ключевым принципом взаимодействия СДС «Интеллометрика» с существующими и создаваемыми системами сертификации высокотехнологичной продукции является взаимное признание сертификатов, что позволяет сократить расходы на подтверждение соответствия в рамках специализированных систем сертификации инновационной продукции.

Формирование органов по сертификации и испытательных лабораторий осуществляется на базе профильных отраслевых организаций, исходя из уровня технологической готовности продукции и услуг ИИ в соответствующей отрасли, наличия нормативно-технической базы, необходимой для проведения сертификационных испытаний.

Испытания алгоритмов ИИ должны проводиться в условиях, близких к предусмотренным условиям эксплуатации, что обеспечивается характеристиками среды испытаний и тестовых НД.

Испытания должны предоставлять данные об определенных условиях работы системы ИИ. Например, существенные факторы эксплуатации строительно-дорожной техники в общем случае можно разделить на пять групп [6]:

- различные погодные условия (например, солнечно/пасмурно/облачно, дождь/ туман/снег и пр.);

- различные виды ландшафта (например, скала, горы, равнина и др.);

- разметка дорожного полотна (для дорожных катков, фрез, асфальтоукладчиков) и/или грунта

(для землеройных машин, погрузчиков и пр.) путем установки дорожных конусов и/или сигнальных лент; - различные виды статических объектов (например, козловой кран, вагончик для рабочих, другая СДТ в нерабочем состоянии, деревья, кустарники и т.д.);

- различные виды динамических объектов (например, рабочие, находящиеся на участке работы СДТ, другая СДТ в рабочем состоянии и пр.).

Выводы

Формирование тестовых НД, репрезентативно отражающих среду функционирования алгоритма ИИ, позволяет получить объективную оценку функциональной корректности СИИ и оценить для предусмотренных условий эксплуатации:

- доверительные интервалы и вероятности прогнозирования погрешностей измерений для определенных условий проведения измерений;

- предельные интегральные риски, связанные с некорректной работой системы ИИ;

- ресурсы, необходимые злоумышленнику для успешного информационного воздействия на измерительную систему с алгоритмами ИИ (опционально, при наличии активного злоумышленника).

В этой связи особенно актуальной является задача формирования испытательных лабораторий

и органов по сертификации технологий ИИ, применяемых в строительной отрасли.

Использованные источники

- Искусственный интеллект в анализе размера и доли строительного рынка — тенденции роста и прогнозы (2024-2029) [Электронный ресурс]. URL: https://www.mordorintelligence.com/ru/industry-reports/artificial-intelligence-in-construction-market.

- СП 333.1325800.2017 Информационное моделирование в строительстве. Правила формирования информационной модели объектов на различных стадиях жизненного цикла. — М.: Стандартинформ, 2018. — 33 с.

- Перспективная программа стандартизации по приоритетному направлению «Искусственный интеллект» на 2021-2024 годы: утв. 22 декабря 2020 года.

- Гарбук С. В. Специальная модель безопасности создания и применения систем искусственного интеллекта // Вопросы кибербезопасности. 2024. № 1 (59). с. 15-23.

- Федеральный закон «О техническом регулировании» от 27.12.2002 № 184-ФЗ.

- Окончательная редакция проекта национального стандарта Российской Федерации «Алгоритмы систем искусственного интеллекта для обнаружения и идентификации препятствий строительно-дорожной техники. Методы испытаний» [Электронный ресурс]. URL: https://tc164.ru/page28499750.html.

Комментарии